Чтобы пользователи узнали о вашем сайте и, к примеру, совершили покупку или прочитали статью — он должен отображаться в поисковых системах, вроде Google и Яндекс. Для этого каждый ресурс проходит индексацию. Этот процесс отличается от ранжирования тем, что при индексации сайт просто попадает в базу данных поисковиков, а при ранжировании — встает на конкретное место.

Мы спросили мнение у экспертов в области веб-оптимизации и рассказали в статье о том, как происходит индексация сайтов и что делать, если ваши страницы не индексируются поисковиками.

Что значит индексация сайта и почему она важна

«Индексирование сайта — это процесс, в ходе которого поисковые системы получают информацию о страницах ресурса. Полученные данные хранятся в базе, которую называют поисковым индексом. Так Яндекс, Google и другие поисковики узнают, что ваш сайт существует и наполнен полезным контентом. Индексация нужна для того, чтобы юзеры могли найти ваши страницы при поиске» — так определяет индексацию Сергей Шабуров, руководитель группы оптимизации сайтов Kokoc Group.

Быстрая индексация страниц сайта в Яндексе

Эксперт Роман Огрин добавляет, что индексация — важный этап запуска любого проекта, на котором планируется активное SEO-продвижение или есть планы по развитию органического трафика. Исключения составляют рекламные форматы, вроде контекстной рекламы, — для них процесс индексации не является ключевым.

Для индексирования поисковик, например Яндекс или Google, отправляет на сайт роботов, они считывают код и регулярно посещают страницы ресурса. Периодичность зависит от того, как часто меняется контент, от количества страниц и объема трафика.

Как происходит индексация сайта

Анастасия Шестова, руководитель направления поискового продвижения в ИнтерЛабс, сравнивает индексацию с добавлением книги в библиотеку: когда определен жанр, автор и название книги, она занимает свое место в библиотеке, и читатель может ее найти. Поэтому индексацию сайта вернее рассматривать как двухэтапный процесс: сначала идет сканирование страниц, затем — их обработка.

Сканирование страниц

Сканирование страниц — это основная задача поискового робота. Когда он попадает на новую страницу, то получает два набора данных:

- Содержание, информацию о сервере и служебные данные.

- Перечень ссылок на страницах.

Затем робот передает данные в обработку, а после — сохраняет в базе. Самый простой способ индексации страниц в рамках домена — создание карты сайта sitemap.xml.

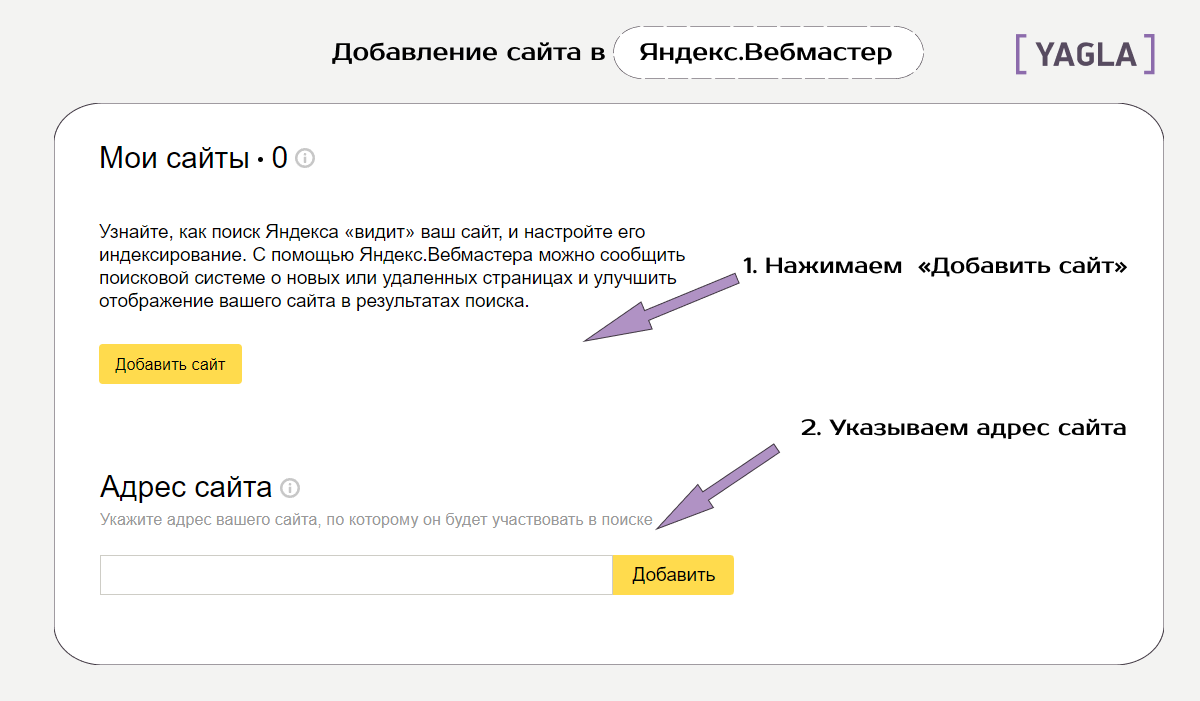

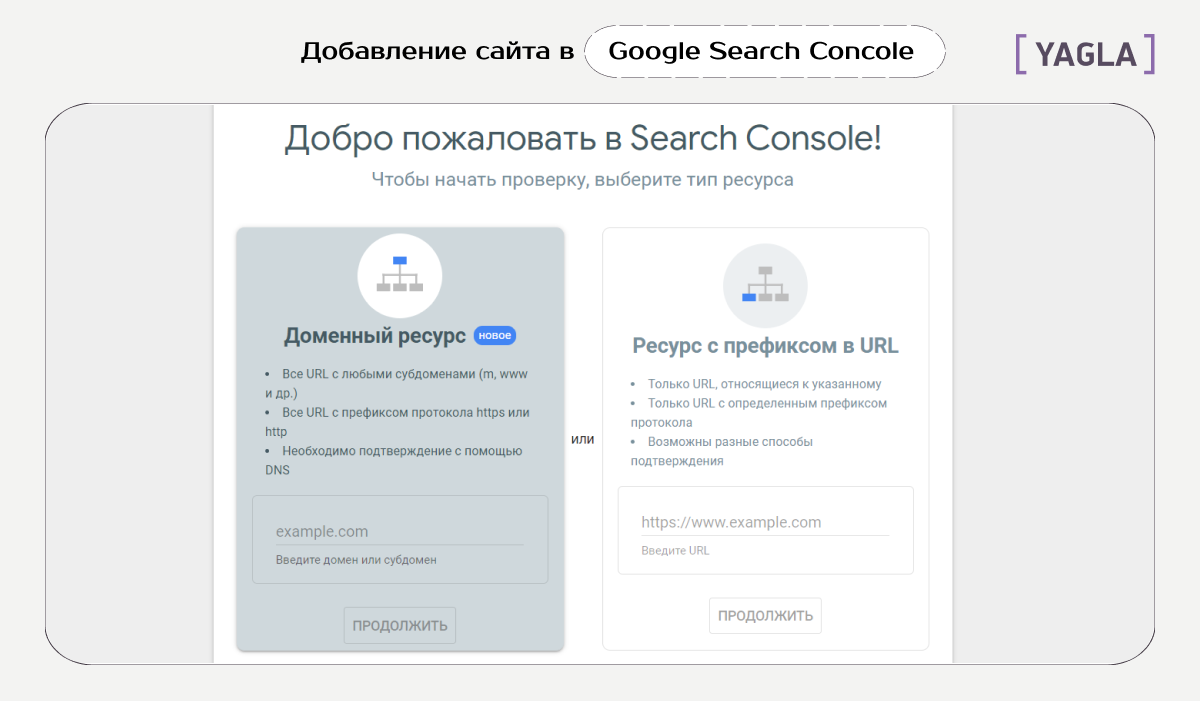

Чтобы Google и Яндекс увидели ваш сайт, нужно cначала добавить его в сервисы, а затем прикрепить ссылку на файл Sitemap в Google Search Console и Яндекс.Вебмастере. Это специальные сервисы для веб-мастеров, которые помогают работать с индексацией.

Как вывести группу вконтакте в топ яндекс и гугл?

Чтобы добавить файл Sitemap в Google Search Console, зайдите в сервис, добавьте свой сайт и перейдите в раздел «Сканирование». В пункте «Файлы Sitemap» выберите «Добавить файл Sitemap» и вставьте ссылку на файл Sitemap.

В Яндекс.Вебмастере путь похож: зайдите в ваш аккаунт, выберите нужный сайт. Затем в левом меню нажмите на раздел «Индексирование» и выберите вкладку «Файлы Sitemap». В строку «Добавить файл Sitemap» вставьте ссылку файла и нажмите «Добавить». Кстати, если вы внесли изменения в карту сайта, то просто отправьте карту на перепроверку, нажав на стрелочки рядом с файлом Sitemap.

Обработка страниц

После сбора роботами информация проходит обработку и потом попадает в базу данных. Это необходимо для ускорения дальнейшего поиска.

В начале программа формирует страницу со всем содержимым: скрипты, эффекты, стили. Важно, чтобы робот имел полный доступ ко всем файлам, потому что без них индексатор не сможет понять структуру.

Вы можете посмотреть, одинаково ли видят страницу пользователи и поисковой робот. Для этого зайдите в Google Search Console, выберите отчет «Посмотреть как Googlebot» в разделе «Сканирование».

Затем робот анализирует текст страницы: упрощает слова и определяет частоту упоминания ключевого слова, проверяет уникальность. Так, если ваш контент уже индексировали в интернете, то у страниц будет низкая уникальность. Значит, робот может не добавить их в поисковый индекс. Поэтому важно наполнять свой сайт уникальным и полезным контентом.

Как проверить индексацию

Эксперты выделяют три способа, чтобы проверить, отображается ли сайт в поисковиках: запрос в поисковой системе, использование бесплатных сервисов для автоматической проверки и использование сервисов для веб-мастеров.

Если значения проиндексированных страниц в Google и Яндекс сильно различаются, это свидетельствует о проблемах в оптимизации сайта.

Дарья Каблаш, основатель маркетингового агентства Dvizh

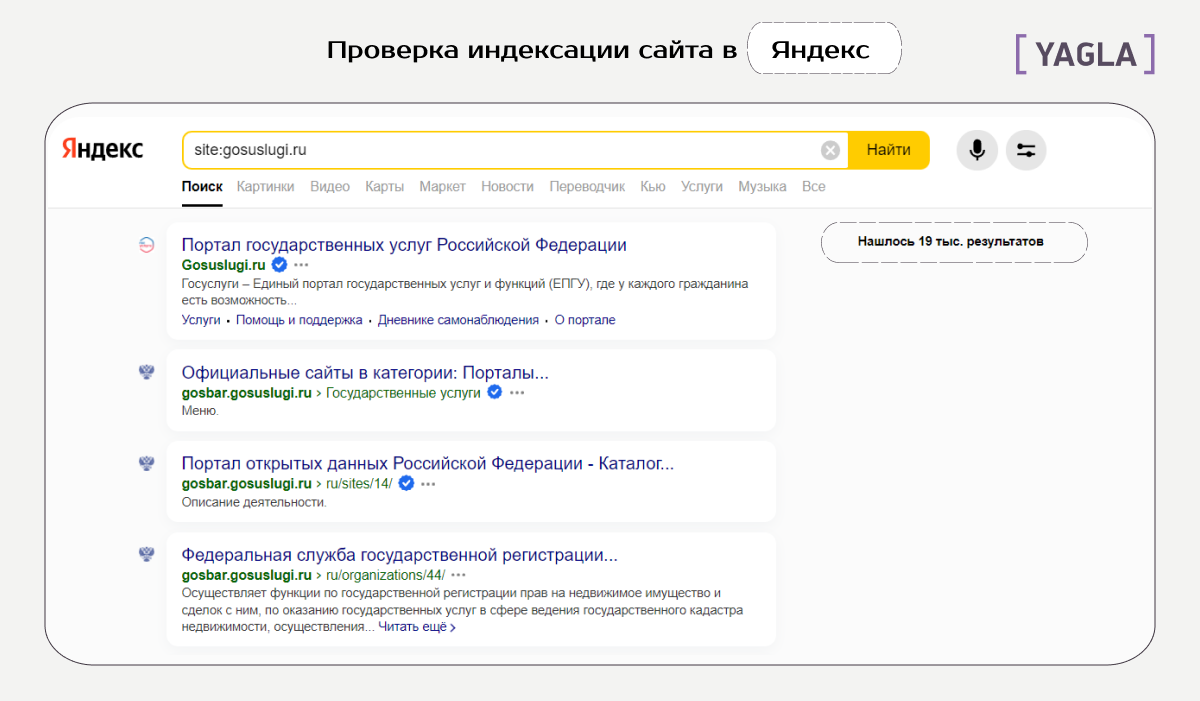

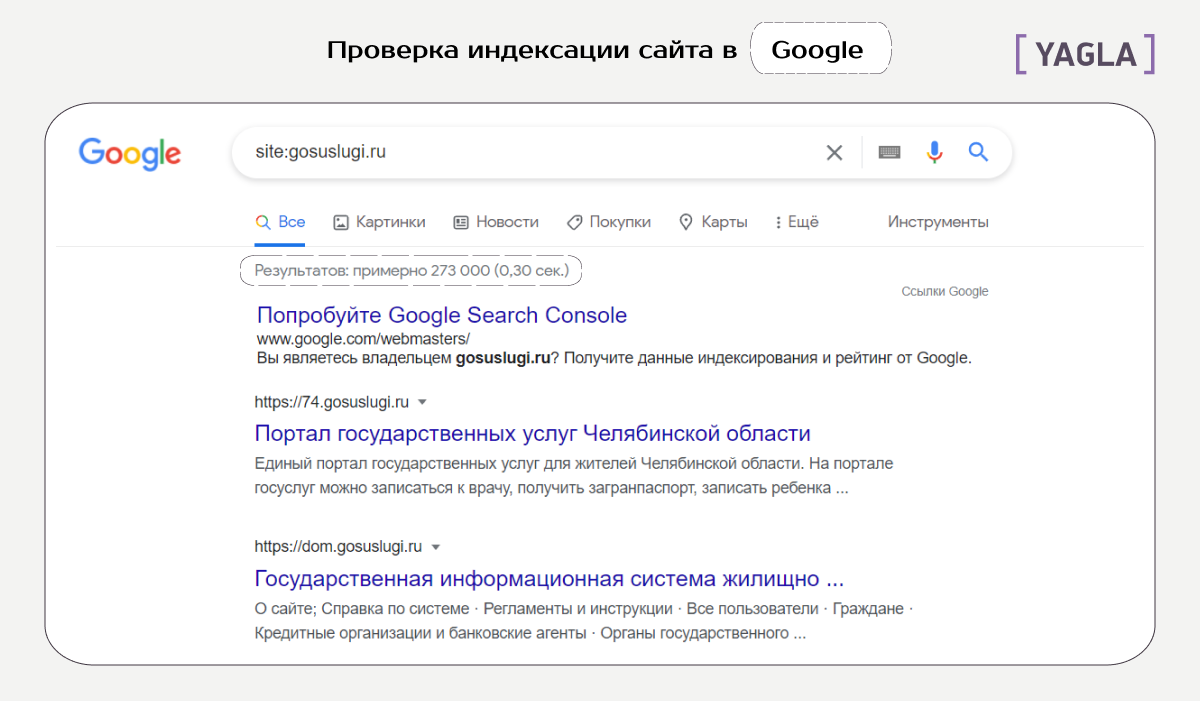

Поисковая строка

Роман Огрин, руководитель группы оптимизации в Kokoc Group, называет специальные операторы самым быстрым и простым способом проверки индексации. Яндекс и Google поддерживают оператор site, который помогает отображать проиндексированные страницы. Базовый синтаксис использования: site:sitename.com

Но поисковые системы могут ограничить работу этих операторов для снижения нагрузки. Поэтому рекомендуют использовать дополнительные способы для проверки индексации.

Бесплатные плагины

«Можно использовать специальные бесплатные сервисы, например, be1.ru и pr-cy.ru. Для проверки введите адрес сайта в специальную строку и нажмите «Проверить». Обычно такие сервисы, помимо количества страниц в индексе популярных поисковиков, предоставляют еще много интересных данных» — Николай Полушкин, директор веб-студии DIUS.

Веб-сервисы Яндекс.Вебмастер и Google Search Console

Сергей Шабуров, руководитель группы оптимизации сайтов Kokoc Group, считает веб-сервисы поисковых систем самым достоверным источником информации о наличии страницы в индексе. В этих инструментах можно получить данные о количестве, динамике индексации, причинах удаления или включения страницы в базу данных, а также многое другое. Минус в том, что доступы к этой информации могут получить только владельцы сайта или те, у кого есть права владельцев.

Эксперт Роман Огрин рассказывает, как именно посмотреть индексацию в Яндекс.Вебмастере и Google Search Console. Оба сервиса сначала надо «привязать» к исследуемому домену и только потом смотреть точную статистику.

В Яндекс.Вебмастере есть раздел «Индексирование» с подразделом «Страницы в поиске». По клику на вкладку «Все страницы» сервис выдает список проиндексированных на данный момент документов. В Search Console аналогичный инструмент — отчет «Покрытие».

Помимо простого анализа страниц в индексе, оба сервиса предоставляют много полезной статистики. Эта информация поможет сделать правильные выводы при проблемах с индексацией.

Например, посмотрите, совпадает ли количество проиндексированных страниц с количеством страниц вашего сайта. Если у вас 240 страниц, а в индексе только 100, это означает, что есть проблемы с индексацией, ведь поисковая система не знает о большей части контента.

Управление индексацией сайта

Текстовый файл robots.txt также позволяет управлять поисковыми роботами с помощью директив.

- Директива Disallow закрывает сайт или конкретные страницы от индексации роботами.

- User-Agent указывает поисковую систему для индексации по написанной инструкции.

- Crawl-delay задает частоту обращения роботов к ресурсу. Работает для Яндекса.

- Clean-param закрывает индексирование с конкретными динамическими параметрами.

- Директива Allow разрешает роботам индексирование отдельных страниц.

Что делать, если сайт не индексируется

Есть множество причин, почему сайт не индексируется. Эксперт Сергей Шабуров условно разделяет причины на технические и контентные. Ниже рассмотрим основные из них с примерами из опыта специалистов.

Технические причины

Сайт может быть случайно закрыт от сканирования роботами или из-за ошибки разработчиков. Это можно определить, если проверить:

- Директиву Disallow в файле robots.txt. Как мы писали выше, эта директива закрывает конкретные страницы от индексации.

- Мета-теги в разделе HTML-документа, например, . Они определяют отношение к сканированию контента в документе.

- HTTP-заголовок X-Robot-Tag — информация о запрете или разрешении индексации сайта в HTTP-заголовках ответа сервера.

- Код ответа сервера. В индекс попадают только доступные страницы с кодом ответа сервера 200 Ок, а ресурсы с другими кодами ответа удаляются. Изменение кода ответа — один из способов управления индексацией.

- Настройки сервера. Для разных IP адресов, User-agent и других параметров серверная часть ресурса может регулировать как скорость, так и саму отдачу информации о странице и ее содержимом.

- Наличие входящих внутренних или внешних ссылок. Индекс может исключать такие страницы.

- Низкий трафик. Это может быть следствием малополезной страницы или отсутствием семантического спроса со стороны пользователей по данному контенту.

Николай Полушкин, директор веб-студии DIUS, делится недавним случаем из практики. «Пришел сайт на бесплатный аудит. Клиент жаловался на резкую просадку трафика. SEO-специалист сразу открыл файл robots.txt и нашел строчку Disallow. Мы сообщили об этом клиенту и объяснили, что сайт закрыт от индексации, и страницы постепенно удаляются из поиска.

Заказчик был удивлен и попросил выяснить, кто и когда это сделал. Недавно компания делала редизайн и наш специалист предположил, что страницы на время работ закрыли от индексации, а потом забыли убрать запрещающую директиву».

Контентные причины

Важно помнить, что индексация занимает некоторое время. Поэтому, если страницы нет в индексе, иногда это может значить, что роботы поисковых систем не успели до нее дойти. Либо есть ошибки в контентном наполнении страниц:

- Отсутствие индексируемого контента. Контент может быть реализован на технологии, которую поисковые системы не умеют считывать или плохо воспринимают к индексации. Так векторная графика, например Flash, не индексируется.

- Контент без пользы или вредный для пользователей. Сюда относят: спам, малый по объему контент, устаревшая информация, которая никогда не будет востребована, наличие вирусов, фишинга.

- Дублирующийся контент. Поисковые системы стараются не индексировать или удалять из выдачи страницы, которые содержат повторяющуюся информацию.

«У нас была такая ситуация с кулинарной онлайн-школой. В Google сайт показал хорошие результаты уже в первый месяц работы и вышел в ТОП-3 по прямым запросам. Но в Яндексе страницы вообще отсутствовали.

Чтобы узнать причину, мы зарегистрировали сайт в Яндекс.Вебмастере и отправили на проверку. Результаты показали критическую ошибку. Дело было в том, что на ресурсе дублировались страницы. Владельцы школы публиковали для разных таргетологов страницы с одинаковым контентом, но разными ссылками. Яндекс видел в этом неуникальный контент и не индексировал страницы.

Мы удалили дублирующиеся страницы, перейдя на utm-метки, и отправили сайт на переиндексацию. Через несколько дней проблема решилась, сайт стал отображаться в Яндексе» — Дарья Каблаш, основатель маркетингового агентства Dvizh.

Иные причины

Более редкие случаи неиндексации могут быть связаны, например, с фильтром «для взрослых».

Сергей Шабуров, руководитель группы оптимизации сайтов Kokoc Group, приводит свежий пример из практики. «Сайт одного из российских операторов мобильной связи перестал ранжироваться по навигационному запросу: » тарифы» в Яндексе. В выдаче присутствовали побочные сайты, а ресурс оператора отсутствовал. Это неслыханная вещь, при учете, что целевая страница и все остальные были в индексе по данным Яндекс.Вебмастера. По данному запросу сайт должен был занимать как минимум несколько строчек поисковой выдачи. Проблема выявилась при переключении настроек поиска с умеренного фильтра на фильтр без ограничений.

Это значит, что страница перешла из основного индекса в специальный “Фильтр для взрослых” или «Adult-фильтр». После обращения в службу поддержки Яндекса обнаружилось, что это ошибка на стороне поисковой системы, так как на странице не было какой-либо специфичной информации».

Также возможен редкий случай неиндексации — «плохая история» домена. В этом случае был куплен домен, на котором ранее был поисковый спам или adult-ресурс, поэтому сайт сразу может быть под фильтром.

«В нашей практике был пример сайта на домене, на котором ранее был размещен белый каталог сайтов. Ресурс индексировался нормально и потом резко пропадал из индекса поисковых систем. Помогли письма в техподдержку Яндекса и отправка страниц на принудительную переиндексацию. Но даже после этого периодически сайт продолжал полностью вылетать из индекса, за этим приходилось отдельно следить. Чтобы таких моментов не было, перед покупкой домена лучше всего проверять его историю» — Анастасия Шестова, руководитель направления поискового продвижения в ИнтерЛабс.

Заключение

Без индексации пользователи не увидят ваш сайт даже при прямом поисковом запросе. Поэтому индексация — обязательный процесс для ресурсов, которым важен органический трафик.

Во время индексации роботы сканируют и обрабатывают информацию на страницах, заносят ее в специальную базу данных — поисковый индекс. Можно легко проверить, есть ли ваши страницы в поисковой выдаче, например, в Google. Самый надежный способ — использование сервисов для веб-мастеров: Яндекс.Вебмастер и Google Search Console.

Часто сайты, которые должны быть проиндексированы, все равно не попадают в поиск. В таком случае нужно проанализировать возможные технические и контентные причины. В редких случаях работы могут убрать ресурс из выдачи из-за ошибки на стороне поисковой системы или плохой истории домена.

Источник: yagla.ru

Как ускорить индексацию сайта в Яндексе и Google

Чем быстрее страница займет место в выдаче поисковой системы, тем быстрее ее смогут увидеть пользователи, и тем больше вероятность, что она будет считаться первоисточником контента.

Нельзя точно сказать, когда боты поисковых систем просканируют страницу и она появится в выдаче. На частоту индексирования страниц ботами влияет:

- Частота обновления контента страниц. Боты составляют краулинговый бюджет сайта на основе данных об обновлении контента. Если страницы не меняются, нет смысла их часто сканировать.

- Поведенческие факторы, которые обрабатывают поисковые боты. Чем лучше ПФ, тем востребованнее сайт у аудитории, а это еще один сигнал к повышению внимания от робота.

- Хостинг. На загруженном хостинге снижается скорость обработки запросов от робота.

Разберем типичные проблемы, с которыми сталкиваются оптимизаторы.

Частые проблемы с индексацией сайта в ПС

Страницы вообще не индексируются

Если роботы и Яндекса, и Google игнорируют страницы сайта, нужно убедиться, что ботам не запретили обход. Проверьте настройки хостинга и файл robots.txt — там не должно быть запрета на индексацию. Также запрет может быть в HTTP-заголовке X-Robot-Tag, который находится в файле конфигурации сервера. Проверить запрет через X-Robots-Tag можно в инструменте бесплатно.

Страницы не индексируются одним из поисковиков

Если либо Google, либо Яндекс не индексируют страницы сайта, проблема может быть в санкциях от этого поисковика. Нужно определить, какие санкции лежат на сайте, и исправить ошибки. Помогут материалы о санкциях Яндекса и фильтрах Google.

Страницы индексируются, но долго

Если приходится долго ждать индексации новых страниц, вариантов может быть много: контент редко обновляется и поэтому боты редко его посещают, страницы не оптимизированы, не участвуют в перелинковке или проблема в чем-то другом. Способы ускорить индексацию мы разберем дальше.

Посмотреть динамику индексации страниц и найти ошибки в SEO можно в сервисе для анализа сайта от PR-CY:

Итак, если страницы не индексируются, то проверьте ограничения, если игнорирует поисковик, то возможны санкции, а если индексирование идет, но долго, это повод попытаться его ускорить.

Как ускорить индексацию страниц

Представитель Google Джон Мюллер на вопрос об индексировании ответил так:

«Лучший способ улучшить процесс индексирования — создавать превосходный, а значит уникальный и убедительный контент. Именно в нем должны нуждаться пользователи, именно его они затем будут рекомендовать другим. Нужно также понимать, что поисковые системы не индексируют абсолютно все, что выложено в сети».

Создавайте превосходный контент, а если ваш контент плохо индексируется, то он недостаточно превосходный. 🙂 Это все, конечно, хорошо, но давайте посмотрим, что конкретно можно сделать, чтобы ускорить процесс.

Отправить страницу на переобход

Можно дополнительно обратить внимание поисковиков на конкретные URL. В Google Search Console и Яндекс.Вебмастере найдите переобход страниц и отправьте нужные URL на индексацию.

В Яндекс.Вебмастере это раздел Индексирование — Переобход страниц. В консоли Google это Инструмент проверки URL.

Массовая отправка страниц на переиндексацию в Google

Есть способ отправлять на повторное сканирование не по одной ссылке за раз, а по 200 URL в день. В этом мог бы помочь бесплатный скрипт, который сделал SEO-отдел компании Journey Further на базе Indexing API Google. Проблема в том, что для его работы понадобится аккаунт в Google Cloud Platform, но в марте Google перестал регистрировать пользователей из России в своем облачном сервисе.

Если вы не из РФ, можете настроить скрипт для массовой переиндексации URL. Для этого нужно:

- Установить node.js.

- Создать сервисный аккаунт в Google Cloud Platform.

- Создать закрытый JSON-ключ.

- Скачать скрипт и вставить ключ вместо содержимого service_account.

- Связать скрипт с Google Search Console: назначить владельцем client_email. Нужен не полный доступ, а именно роль «Владелец».

- Перейти по ссылке, выбрать сервисный аккаунт, который вы создали, и включить Index API.

- В папке скрипта открыть файл urls и внести в него до 100 URL. Если нужно больше, можно отправить еще до 100 во втором заходе. В день можно отправлять не больше 200 ссылок.

- Вызвать PowerShell, зажав Shift и правую кнопку мыши в окне.

- Прописать node index.js.

- Готово, через несколько секунд появится 200 ОК.

Проверить разрешения в robots.txt

В файле robots.txt веб-мастер прописывает рекомендации для поисковых ботов Яндекса и Google. Можно запретить ботам посещать некоторые страницы, для этого есть директива «disallow», «nofollow», можно использовать мета-тег «noindex» или «none». Тогда при следующем посещении сайта бот увидит запрет и может к нему прислушаться. А может и не прислушаться.

Как говорит Ксения Пескова, SEO-TeamLead в Siteclinic:

«Если вы закроете сканирование в файле robots.txt — это всё равно может не уберечь от индексации страницы, так как в файле мы запрещаем сканирование, и это всего лишь рекомендации, а не прямое указание».

В любом случае, лучше проверить файл robots, вдруг там стоят запреты, к которым прислушались боты поисковых систем.

Создать Sitemap — Карту сайта

Карта сайта помогает поисковым ботам понять структуру ресурса и обнаруживать обновления контента.

Почитать по теме:

Как составить карту сайта (файл Sitemap)

Для ускорения индексации карту можно сделать динамической, то есть по мере создания новых страниц она сама будет обновляться. Для проектов на конструкторах сайтов, например, на Tilda, карта по умолчанию динамическая, для CMS есть плагины и отдельные сервисы. К примеру, на WordPress с этой задачей справится All in One SEO Pack.

Можно обновить файл Sitemap вручную. Обновленные страницы Google рекомендует отметить в Карте тегом < lastmod >. Обновленный файл отправьте с помощью специального отчета. Не стоит загружать один и тот же файл повторно: если вы ничего не поменяли в Карте сайта, никаких изменений не будет.

Но опять же, ссылки в Карте сайта — это рекомендации, важнее создать грамотную структуру сайта и организовать внутреннюю перелинковку.

Проверить структуру и перелинковку разделов

На сайте не должно быть страниц, оторванных от других. Если на страницу не ведут ссылки с категорий, разделов и других страниц, поисковикам сложнее определить ее релевантность и неоткуда перейти на нее для сканирования. Такие страницы называют сиротами.

Нужно встроить их в структуру сайта. К примеру, в этой схеме каждая страница имеет ссылку с родительской категории, но они вполне могут линковаться и между собой:

Еще один момент, который влияет на поведение бота — это Click Distance from Index (DFI), то есть количество кликов от главной до текущей страницы. Чем оно меньше, тем важнее считается страница, тем больший приоритет она получит с точки зрения бота. Приоритетные страницы он смотрит первее остальных.

DFI не определяется по числу директорий в URL, они могут не совпадать. Например, если на главной странице будет ссылка на хит продаж — конкретную модель холодильника Atlant, то DFI будет равен двум. Но при этом карточка модели может находиться в каталоге и подразделе каталога, тогда директорий будет больше — site.com/shop/refrigerator/one_chamber_refrigerators/atlant/h_1401_100.

Если страница не индексируется, проверьте ее расположение в структуре сайта и количество кликов до нее с главной.

Александр Шестаков, руководитель продукта Links.Sape:

«Внутренняя перелинковка положительно влияет сразу на несколько параметров, например, увеличивает трафик и упрощает работу поисковых роботов. Также ускорению индексации способствуют внешние ссылки из качественных источников (сайтов с высоким трастом и уровнем трафика).

При этом любую внешнюю ссылку можно усилить, закупив дополнительные ссылки на страницу, с которой она исходит. Такая стратегия многоступенчатого усиления называется Tier 2.

Существуют и более сложные разветвленные стратегии, например Tier 3-5. Эти методы приводят к увеличению веса страницы, и не только качественно ускоряют индексацию сайта, но и влияют на рост позиций. При этом усиление ссылок не вызывает у поисковых систем подозрения в манипуляциях».

Взять за правило обновлять контент

Поисковики ценят, когда веб-мастер следит за актуальностью контента, исправляет его и добавляет что-то новое. Регулярно обновляющийся сайт бот будет чаще сканировать. Чем реже обновлять контент, тем реже боту понадобится его перепроверять.

Материал по теме:

Как переупаковать контент

Публиковать ссылки в соцсетях и на других площадках

Найдите сторонние сайты по вашей тематике, где можно оставлять ссылки или публиковать посты, и размещайте таким образом ссылки на новые материалы.

CTO компании Pear Advert Иван Самохин:

«Вопрос индексации остается актуальным не только для вашего сайта, но и для страниц с ссылками на ваш ресурс. Убедитесь в том, что страницы с внешними ссылками находятся в индексе поисковых систем, иначе оказать положительное влияние на продвижение сайта они не смогут».

Вы можете договориться о партнерстве с площадкой, близкой вам по тематике, и обмениваться ссылками. Главное, что размещения ссылок должны выглядеть естественными и подходить по теме. К примеру, ссылка на магазин рыболовных снастей будет уместно выглядеть на форуме рыболовов или туристическом портале. Ищите справочники, форумы, другие соцсети, отзовики, сервисы вопросов и ответов и другие площадки для размещения.

Материал по теме:

Как получить ссылки на сайт бесплатно

Если вы ведете страницы в социальных сетях, размещайте на них анонсы ваших новых материалов. С помощью разметки OpenGraph можно задать ссылке красивое превью с нужной картинкой и заголовком, и получить переходы пользователей на страницу.

Отследить популярные страницы поможет сервис сквозной аналитики и коллтрекинга Calltracking.ru. С его помощью вы сможете понять:

- с каких страниц поступают целевые и нецелевые обращения;

- есть ли проблемы с версткой на страницах сайта;

- на какие страницы увеличивать трафик и запускать рекламу.

Сервис помогает оптимизировать рекламу с учетом всех лидов и их стоимости.

Ускорить загрузку сайта

Ограничивать индексацию может долгий ответ сервера. По словам Джона Мюллера из Google, если в среднем это время составляет больше одной секунды, Google не будет сканировать столько страниц, сколько мог бы.

Медленная загрузка страниц вредит им по всем параметрам: пользователи не ждут, а поисковые системы считают страницы некачественными и могут даже понизить сайт в выдаче, если проблема с загрузкой есть у всех страниц.

Материал по теме:

Полное руководство по ускорению сайта

Многое можно проверить на сайте автоматически. Поможет сервис для анализа сайта: он оценит загрузку сайта и отдельно найдет конкретные страницы, на которых есть проблема со скоростью.

Аудит сайта с проверкой внутренних страниц доступен на всех платных тарифах.

Вы можете попробовать неделю бесплатно и оценить все возможности сервиса.

FAQ: что еще влияет на скорость индексации сайта

Как страницы вне индекса могут повлиять на отношение поисковика к сайту?

Качество контента на сайте поисковики оценивают только по проиндексированным страницам.

Тег noindex может влиять на индексацию страницы после его снятия?

По словам Джона Мюллера из Google, у веб-мастера не будет проблем с реиндексацией URL, на которых когда-то был noindex.

Как редирект влияет на индексацию страниц?

Джон Мюллер утверждает, что поисковик скорее всего не проиндексирует конечный URL при использовании ссылок с 301 редиректом.

Как ускорить индексацию страниц, которые были 404?

Если адрес страницы отдавал 404 и не был индексирован, на индексирование может потребоваться некоторое время. Как советуют Seroundtable, можно создать новый URL для этого контента и настроить 301 редирект со старого адреса, либо запросить повторное сканирование URL.

Как поисковики относятся к URL c хэшами?

URL с хешами поисковик не проиндексирует. То есть ссылка https://site.ru/news/p/statya проиндексируется, а ссылка на конкретную часть статьи — https://site.ru/news/p/statya#step — нет.

Расскажите, какие способы ускорить попадание в индекс знаете вы? Добавьте в комментариях, если мы что-то упустили в материале.

Источник: pr-cy.ru

Как решить проблемы с индексацией сайта в Google и Яндексе

Кратко самое важное об основах: как решить проблемы с индексацией и ускорить ее в Яндексе и Google.

1448 просмотров

Привет! Это PR-CY, мы делаем сервис для проверки SEO и позиций в ПС. Попробуйте прогнать проверку по своему сайту и посмотрите, какие ошибки он найдет.

В статье разберем типичные проблемы, а потом поговорим об ускорении. Постараемся лаконично)

Проблемы с индексацией:

❌ Страницы вообще не индексируются

Если роботы и Яндекса, и Google игнорируют страницы сайта, нужно убедиться, что ботам не запретили обход.

Проверьте настройки хостинга и файл robots.txt — там не должно быть запрета на индексацию.

Также запрет может быть в HTTP-заголовке X-Robot-Tag, который находится в файле конфигурации сервера. Проверить запрет через X-Robots-Tag можно в инструменте бесплатно.

❌Страницы не индексируются одним из поисковиков

Если либо Google, либо Яндекс не индексируют страницы сайта, проблема может быть в санкциях от этого поисковика.

Нужно определить, какие санкции лежат на сайте, и исправить ошибки. Проверьте уведомления о Вебмастере и Консоли, часть санкций сопровождаются письмом от поисковика. Подробно в материалах о санкциях Яндекса и фильтрах Google.

❌ Страницы индексируются, но нужно долго ждать

Вариантов может быть много: вы редко обновляете контент, поэтому боты редко его посещают, страницы не оптимизированы, не участвуют в перелинковке… Проблема может быть в других ошибках на сайте, например, в куче ошибочных лишних страниц, сгенерированных движком, на которые тратится время.

Посмотреть динамику индексации страниц и найти ошибки в SEO можно в сервисе для анализа сайта:

Итак, если страницы не индексируются, то проверьте ограничения, если игнорирует поисковик, то возможны санкции, а если индексирование идет, но долго, это повод попытаться его ускорить.

Как ускорить индексирование:

Лучший способ улучшить процесс индексирования — создавать превосходный, а значит уникальный и убедительный контент. Именно в нем должны нуждаться пользователи, именно его они затем будут рекомендовать другим

Джон Мюллер, представитель Google

Ага, классно. Создавайте превосходный контент, а если ваш контент плохо индексируется, то он недостаточно превосходный…

Что реально можно сделать, чтобы ускорить процесс.

1. Отправить страницу на переобход

Найдите переобход страниц в Google Search Console и Яндекс.Вебмастере и отправьте нужные URL на индексацию.

В Яндекс.Вебмастере это раздел Индексирование — Переобход страниц. В консоли Google это Инструмент проверки URL.

2. Проверить разрешения в robots.txt

В файле robots.txt веб-мастер прописывает рекомендации для поисковых ботов Яндекса и Google. Можно запретить ботам посещать некоторые страницы, для этого есть директива «disallow», «nofollow», можно использовать мета-тег «noindex» или «none». Тогда при следующем посещении сайта бот увидит запрет и может к нему прислушаться.

А может и не прислушаться — это всего лишь рекомендации, а не прямое указание. ♂

3. Взять за правило обновлять контент

Поисковики ценят, когда веб-мастер следит за актуальностью контента, исправляет его и добавляет что-то новое. Регулярно обновляющийся сайт бот будет чаще сканировать. Чем реже обновлять контент, тем реже боту понадобится его перепроверять.

4. Создать динамическую Sitemap

Для ускорения индексации карту можно сделать динамической, то есть по мере создания новых страниц она сама будет обновляться.

Для проектов на конструкторах сайтов, например, на Tilda, карта по умолчанию динамическая, для CMS есть плагины и отдельные сервисы. К примеру, на WordPress с этой задачей справится All in One SEO Pack.

5. Пометить обновления в Sitemap

Можно указать обновленные файлы в Sitemap вручную. Google рекомендует отметить страницы в Карте тегом < lastmod >и отправить страницу на переобход.

Но, опять же, ссылки в Карте сайта — это рекомендации.

6. Проверить структуру и перелинковку разделов

На сайте не должно быть страниц, оторванных от других. Если на страницу не ведут ссылки с категорий, разделов и других страниц, поисковикам сложнее определить ее релевантность и неоткуда перейти на нее для сканирования.

Такие страницы называют сиротами.

Нужно встроить их в структуру сайта.

В этой схеме каждая страница имеет ссылку с родительской категории, но они могут линковаться и между собой:

На поведение бота влияет количество кликов от главной до текущей страницы. Бот переходит на страницы по ссылкам с главной. Чем меньше кликов от главной до искомой страницы, тем она важнее, тем быстрее он до нее доберется и просканирует.

Если страница не индексируется, проверьте ее расположение в структуре сайта и количество кликов до нее с главной.

7. Ускорить загрузку сайта

Ограничивать индексацию может долгий ответ сервера. По словам Джона Мюллера из Google, если в среднем это время составляет больше одной секунды, Google не будет сканировать столько страниц, сколько мог бы.

Сомневаемся, что так уж много сайтов загружаются медленнее минуты, но всё возможно. На всякий случай проверьте скорость в сторонних инструментах.

Многое из перечисленного можно проверить автоматически в сервисе для анализа сайта. Ту же скорость — он быстро проанализирует этапы загрузки и отдельно найдет конкретные страницы, на которых есть проблема со скоростью.

Оцените пост, если было полезно 🙂 И напишите в комментариях, если вам есть что добавить к списку.

Источник: vc.ru