Здравствуйте, дамы и господа, в этой статье хочу рассказать о том, как я блокирую вредных ботов, например, ботов ahfers, Semrush, PetalBot, Majestic, Megaindex и многих других. В целом, боты, которые активно копаются по сайту, создают очень много проблем. И на определённом этапе начинают съедать огромное количество ресурсов сервера, на котором расположен ваш сайт.

Содержание скрыть

Ботов необходимо блокировать

Мало того что боты создают дополнительную колоссальную нагрузку на сервер, что выльется в оплату дополнительных ресурсов для оного. Ну или в более дорогой тариф для хостинга.

Но есть более серьёзная проблема: боты собирают информацию о вас. Какой-нибудь SemRush, Majestic или LinkPad предоставит много информации о вашем сайте для конкурентов. О сетке сайтов-сате л литов , с помощью которой вы продвигаетесь, о трафике, о ссылочном профиле и всех анкорах, с помощью которых продвигаетесь.

В общем, благодаря информации, которую собирают данные сервисы, ваш сайт у конкурентов как на ладони. Так что ботов нужно блокировать, особенно если у вас коммерческий проект.

ОБХОД ИРИСА | РЕЙД БОТ ВК на Python3 | Спам 2022 / лаги бесед

Но просто знайте, что чем старше ваш сайт и заметнее в сети, тем больше ботов на него будет приходить. Сначала их численность будет незначительной, а создаваемая нагрузка не будет представлять собой проблему.

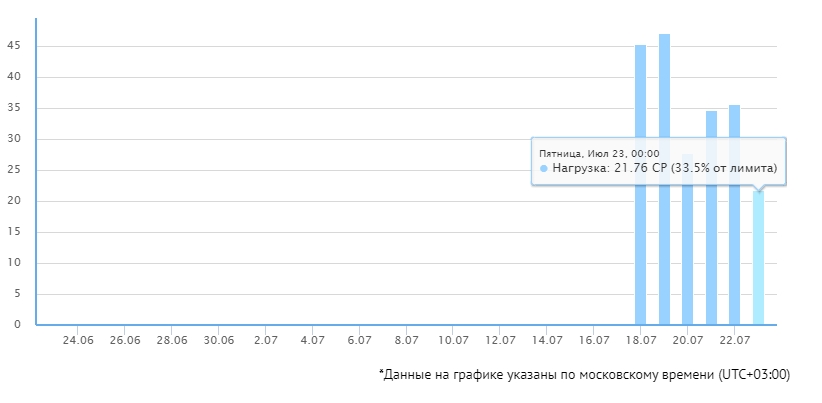

Со временем ботов станет очень много, ресурсов хостинга или сервера не будет хватать. Банально, на моём сайте возникла такая ситуация. Мне даже пришлось перевести сайт на другой хостинг, чтобы хватало ресурсов, но и там ресурсов хватало почти вплотную.

Тогда я решил не лениться и заблокировать плохих ботов. Несколько дней отлавливал тех, кто посещал мой сайт, потом заблокировал через . htaccess.

Нагрузка на сервер упала очень даже заметно. Конечно, 20-30% — разница не самая большая, но чем крупнее сайт, тем больше ботов на нём будет, соответственно, эти 20-30% разницы превратятся в переплаты за хостинг или VPS.

Конечно, результат может показаться не самым впечатляющим, но оно того стоило. Теперь мне не нужно докупать дополнительные CP или переходить на тариф подороже, соответственно, простой блок ботов позволяет сэкономить деньги.

Вам рекомендую сделать то же самое.

Как блокировать плохих ботов

Разделим ботов на две части:

- Полезные. Боты поисковых систем и их сервисов. Например, YandexBot, GoogleImage. Их блокировать нельзя, это плохо скажется на ваших позициях в поисковых системах.

- Плохие боты. Разные сервисы вроде SemRush, Ahfers, Megaindex и т. п. В общем, именно их будем отрезать.

После блокировки всевозможных плохих ботов у вас значительно упадёт нагрузка на сервер. Если от вашего хостера приходят уведомления, что превышен лимит процесс о рного времени ( CP ), то самое время отрезать часть плохих ботов. Какие ро боты и краулеры конкретно увеличивают нагрузку, можете увидеть в логах.

СОХРАНЕНКИ ВК БОТ #shorts

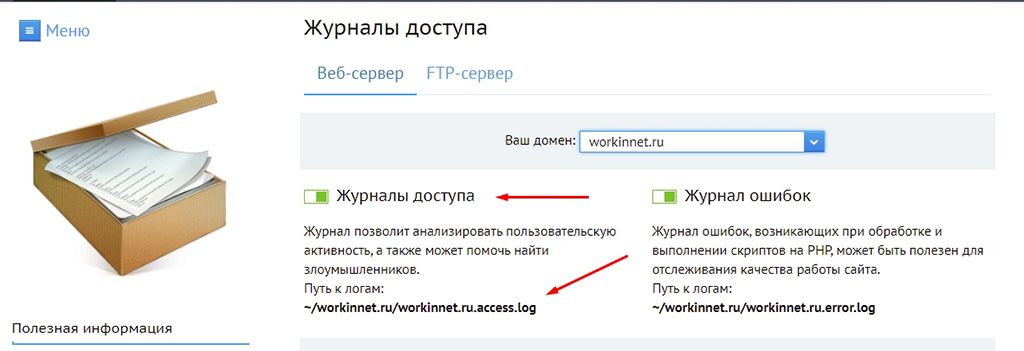

Найти логи мож но на сервере, как правило, логи посещений пишутся в отдельные журналы. Например, в Fozzy их можно увидеть в разделе «Статистика» в панели DirectAdmin, на Бегет придётся отдельно включить «Журналы доступа» в панели управления хостингом. В общем, если сами не знаете, как это сделать, задайте вопрос вашему хостеру, они с этим помогут.

После вы увидите примерно такую картину, где в логах будут записаны куча User-Agent, разнообразных IP, а также время посещения.

Бездумно блокировать всё подряд не рекомендую. Нужно вычленить именно бота, если блокировать всех «юзер-агентов», то заблокируете и реальных посетителей.

Многие боты себя идентифицируют. Таких отсечь легче всего.

Некоторые боты себя не идентифицируют или даже маскируются под краулеры. Их отсекать можно по IP- адресам, но это практически бесполезно, так как у вредоносных роботов IP- адреса постоянно меняются.

Также можно настроить фильтрацию посредством обратных DNS- запросов, но это задача непростая, так что в этой статье ограничимся разбором блокировки идентифицируемых ботов, а также наиболее «наглых» IP- адресов.

Конечно же, я опубликовал список полезных и вредных ботов . Чтобы было ясно, что и почему я блокирую. Периодически списки буду пополнять, а также редактировать данную статью. Но та статья касается только тех ботов, которых можно идентифицировать.

Начнём с варианта блокировки через файл . htaccess, ибо он самый эффективный.

Блокировка ботов через .htaccess

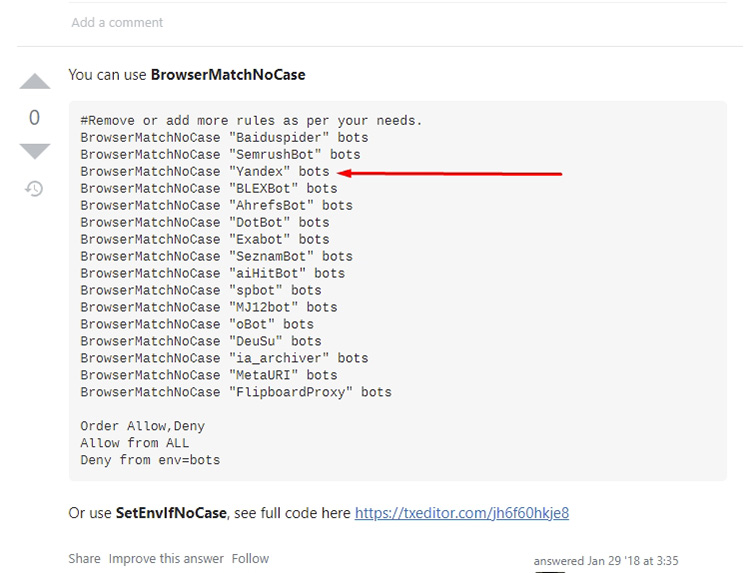

Этот вариант самый лучший, так как боты и краулеры частенько игнорируют директивы из robots.txt. Есть вариант блокировать с помощью команды SetEnvIfNoCase User-Agent или через ReveriteCond. Первый способ получше. Ну, лично для меня.

В данном списке я собрал именно тех ботов, которых выловил на своём сайте. И блокировка сработала. В логах вы увидите, что ботам выдаётся ответ сервера 403, соответственно, нагрузка на ваш сайт снизится.

Учтите, на многих сайтах есть аналогичные списки для блокировки ботов и краулеров. Рекомендую их бездумно не копировать, подобные директивы часто сделаны людьми из-за рубежа, соответственно, там бездумно блокируют краулеры Яндекс и Mail.ru, что плохо скажется на позициях сайта в Яндекс.

Банальный пример кода:

И многие контент-мейкеры из СНГ бездумно копируют такие коды себе на сайты. Так что смотрите внимательно и анализируйте.

В своих вариантах я опубликовал только тех ботов, которые атакуют мой сайт. В ваших логах могут быть иные роботы и краулеры.

Итак, вариант блокировки через . htaccess. Всем ботам будет выдаваться ответ сервера 403, то бишь «доступ запрещён». Это серьёзно сократит нагрузку на ваш сайт.

У себя использую такой код, он оказался вполне работоспособным:

#MJ12bot блокировать только в том случае, если не работаете с Majestic. Например, если работаете на биржах ссылок (Gogetlinks, Miralinks), то там данные Majestic очень важны и тогда лучше его не блокировать. #Slurp — поисковой краулер Yahoo!, если ваш сайт ориентирован на зарубежную аудиторию и есть трафик с Яхуу, лучше не блокировать. #FlipboardRSS и FlipboardProxy блокировать только в том случае, если не ориентированы на Flipboard SetEnvIfNoCase User-Agent «BlackWidow|AhrefsBot|BLEXBot|MBCrawler|YaK|niraiya.com|megaindex.ru|megaindex.com|Megaindex|MJ12bot|SemrushBot|cloudfind|CriteoBot|GetIntent Crawler|SafeDNSBot|SeopultContentAnalyzer|serpstatbot|LinkpadBot|Slurp|DataForSeoBot|Rome Client|Scrapy|FlipboardRSS|FlipboardProxy|ZoominfoBot|SeznamBot|Seekport Crawler» blocked_bot Order Allow,Deny Allow from all Deny from env=blocked_bot

Потом в логах можете увидеть, что заблокированным ботам выдаётся ответ сервера 403:

Соответственно, бот не сможет парсить контент, а также скачивать данные сайта, например, rss- ленты или другие фиды.

Есть ещё один вариант кода, работать может не на всех серверах:

RewriteEngine On RewriteCond % ^BlackWidow [OR] RewriteCond % ^AhrefsBot [OR] RewriteCond % ^BLEXBot [OR] RewriteCond % ^MBCrawler [OR] RewriteCond % ^YaK [OR] RewriteCond % ^niraiya.com [OR] RewriteCond % ^megaindex.ru [OR] RewriteCond % ^megaindex.com [OR] RewriteCond % ^Megaindex [OR] #MJ12bot блокировать только в том случае, если не работаете с Majestic. Например, если работаете на биржах ссылок (Gogetlinks, Miralinks), то там данные Majestic очень важны и тогда лучше его не блокировать.

RewriteCond % ^MJ12bot [OR] RewriteCond % ^SemrushBot [OR] RewriteCond % ^cloudfind [OR] RewriteCond % ^CriteoBot [OR] RewriteCond % ^GetIntent Crawler [OR] RewriteCond % ^SafeDNSBot [OR] RewriteCond % ^SeopultContentAnalyzer [OR] RewriteCond % ^serpstatbot [OR] RewriteCond % ^LinkpadBot [OR] #Slurp — поисковой краулер Yahoo!, если ваш сайт ориентирован на зарубежную аудиторию и есть трафик с Яхуу, лучше не блокировать. RewriteCond % ^Slurp [OR] RewriteCond % ^DataForSeoBot [OR] RewriteCond % ^Rome Client [OR] RewriteCond % ^Scrapy [OR] #блокировать только в том случае, если не ориентированы на Flipboard RewriteCond % ^FlipboardRSS [OR] RewriteCond % ^FlipboardProxy [OR] RewriteCond % ^ZoominfoBot [OR] RewriteCond % ^SeznamBot [OR] RewriteCond % ^Seekport Crawler RewriteRule ^.* — [F,L]

Работать данные варианты будут только с теми ботами, которые себя идентифицируют. Если же боты маскируются под другие краулеры или притворятся реальными посетителями, то такие методы не сработают.

Можно их банить по IP, но об этом чуть дальше.

Блокировка ботов через robots.txt

Некоторые боты можно банить через файл robots.txt. Но работает это только при одном условии: если робот или краулер не игнорирует директивы, прописанные в этом файле. По своим логам видел, что многие боты даже не запрашивают этот файл никогда, соответственно, директив в нём даже не увидят.

В общем, метод практически бесполезен, достал какой-то бот? Баньте на уровне сервера, например, через . htaccess, как предложил выше. Но всё же покажу. Сработает только с роботами и краулерами, которые себя идентифицируют.

Пишем такой код:

User-agent: DataForSeoBot Disallow: /

В общем, мы запретили обход сайта определённому User-Agent. Но, как уже сказал, бот может просто проигнорировать данную директиву.

Также можем через файл robots.txt не только заблокировать бот, а, например, указать скорость обхода, чтобы он продолжил находиться на сайте, но сильно его не грузил.

User-agent: SafeDNSBot Disallow: Crawl-delay: 3 # пауза в 3 секунды между запросами

Crawl-delay позволяет установить задержку между запросами, но данная директива считается устаревшей, большинство ботов её игнорирует, соответственно, её использование не выглядит целесообразным.

В общем, на robots.txt нельзя надеяться при блокировке ботов, так как большей частью роботов этот файл попросту игнорируется.

Блокировка ботов и краулеров по IP

Бывает, в логах попадаются очень наглые боты, которые не идентифицируют себя, но генерируют большую нагрузку на сервер. Защитить от них может либо какая-нибудь AntiDDoS- система, капча и тому подобные фишки, либо блокировка по IP.

Блокировка по IP целесообразна только тогда, когда определённый бот посылает много запросов с 1-го IP- адреса.

Но, как правило, в этом мало смысла, у ботов, как правило, много IP в запасе, соответственно, при дискредитации 1-го адреса бот быстро появится с другого.

Но иногда данный вариант помогает. Но всегда проверяйте IP перед блокировкой, самым «наглым» IP в логах может оказаться ваш собственный. Также можно чисто случайно забанить IP краулеров Яндекс или Google.

Код для блокировки выглядит так:

Order Allow,Deny Allow from all Deny from 149.56.12.131 85.26.235.123 185.154.14.138 5.188.48.188 88.99.194.48 47.75.44.156

Каждый новый IP в список добавляйте через пробел.

Блокировка ботов пойдёт вашему сайту на пользу

Чуть-чуть разгрузит сервер, а также информации о вашем сайте у конкурентов будет поменьше, так что не стесняйтесь и блокируйте. Инструкцию приложил. Конечно, если ваш сайт усиленно долбят боты с разных IP и никак себя не идентифицируют, придётся подумать о более серьёзных методах защиты, но частенько для того, чтобы снизить нагрузку на сервер будет достаточно тех методов, что предложил выше.

На этом с вами прощаюсь, желаю успехов, а также поменьше вредных ботов на сайте!

Насколько публикация полезна?

Нажмите на звезду, чтобы оценить!

Средняя оценка 4.6 / 5. Количество оценок: 18

Оценок пока нет. Поставьте оценку первым.

Источник: workinnet.ru

Как создать команду бан? Python-VK?

Как создать команду бан, я сделал что бы при ответе сообщения и надписи бан он банил юзера, но есть но, я баню изера, и как бы бот на него не отвечает в беседе, но я не могу много банить, т.к в ban.txt сразу много ид людей, и бот считывает как один, и не понимает, как сделать что бы он читал по одному ид в текстовом сообщение? Пожалуйста пример: кодом.

- Вопрос задан более трёх лет назад

- 1021 просмотр

Комментировать

Решения вопроса 0

Ответы на вопрос 2

yay ✌️ t.me/kshnkvn

for line in open(‘ban.txt’, ‘r’): ban_function(line)

При условии, что в ban.txt каждый ID с новой строки.

Ответ написан более трёх лет назад

Что за ban_function(line)?

Я если что новичок)

NooBick, вы-же написали

я сделал что бы при ответе сообщения и надписи бан он банил юзера

Соответственно у вас должно быть что-то вроде:

def ban_function(): »’ Тут функция, которая банит пользователя »’

Прости за тупые вопросы, но почему у меня так?

Внизу тестовый файл, сверху терминал.

Внизу тестовый файл, сверху терминал.

Для ботов VK лучше использовать базу данных(Postgresql, mysql). И при команде бан, менять значение в базе данных и вводить ограничение в боте.

Пример: (Просто пример)

sql.execute(f»SELECT (параметр отвечающий за статус игрока) FROM (таблица в бд) WHERE user_id = «) if sql.fetchall() == «banned»: send_mess(peer_id, «Вы забанены.»)

Пример команды бан:

def ban_function(user_id, peer_id): sql.execute(f»UPDATE (таблица) SET (параметр отвечающий за бан) = ‘banned’ WHERE user_id = «) send_mess(peer_id,»Игрок успешно забанен!»)

Примеры не рабочие, что-бы они работали нужно писать код на их основе.

Советую вам почитать про базы данных.

Источник: qna.habr.com

6 способов забанить и прогнать ботов с вашего сайта

Статьи

Автор cryptoparty На чтение 6 мин Опубликовано 12.12.2019

Не позволяйте вредоносным ботам атаковать ваш сайт и влиять на него.

Посетители сайта не всегда люди из плоти и крови: иногда это боты.

Боты в основном просматривают сайты для сбора статистики для поисковых систем, таких как Google и Yandex, но есть также боты, которые собирают информацию, создают фальшивые аккаунты, распространяют вирусы или комментируют спамом на автопилоте – и это те самое вредоносные боты, которые могут нанести наибольший ущерб.

Внезапное нападение ботами на сайт может быть ошеломляющим, и это может стать кошмаром для администратора сайта.

Далее мы расскажем, как можно определить, какие боты что делают, и покажем несколько практических способов, как изгнать ботов с вашего сайта.

Поисковые боты и спам-боты

Некоторые боты не столь страшны.

Поисковые роботы заходят на ваш сайт, чтобы каталогизировать новую информацию для поисковых систем, и вы как правило захотите, чтобы такой тип ботов просматривал ваш сайт.

Это тот самый процесс,который помогает поисковым системам индексировать ваш сайт среди результатов поиска.

Для администратора сайта очень важно определить ботов поисковой системы по сравнению с реальным трафиком, чтобы получить точную картину того, сколько посетителей и просмотров составляют люди.

Если у вас есть Google Analytics, обратитесь к расширенным настройкам, и вы можете разделить роботов поисковых систем и трафика, чтобы увидеть, как поисковые системы и люди смотрят ваш сайт.

Помимо вашего стандартного поискового бота, вы также можете столкнуться с различными спам-роботами.

Это наиболее опасные боты, от которых вы должны пытаться избавиться, когда они появляются.

Иногда они распространяют вирусы; в других случаях они спамят или заполняют сайт фальшивыми аккаунтами.

Обнаружение спам-ботов

- Увеличение числа новых учетных записей, обычно с несколькими спам-сообщениями или без таковых.

- Увеличение количества комментариев, которые не имеют ничего общего с комментариями, иногда со ссылками или без

- Пользователи жалуются на спам в своих почтовых ящиках или в почтовом ящике.

- Увеличение количества спама, попадающего в почтовый ящик, связанный с вашим сайтом.

- Иногда это может быть иррационально большое увеличение посетителей сайта без увеличения активности, что может указывать на то, что боты собирают информацию.

Присутствие вредоносных ботов может быть кошмаром, особенно когда их задача – спамить ваш сайт ссылками на вирусы или нелегальными ссылкамми.

Как только вы заметили признаки того, что бот делает что-то кроме индексации для поисковых систем, попробуйте выполнить некоторые из следующих шагов.

1 Настройте аутентификацию

Если на вашем веб-сайте используются учетные записи пользователей, проверка подлинности при регистрации может сократить количество учетных записей ботов, которые могут пытаться зарегистрироваться.

Проверка подлинности при регистрации использует номер телефона или адрес электронной почты, прикрепленный к учетной записи, в качестве «проверочного кода», прежде чем пользователю будет разрешено зарегистрироваться.

Это легко выполнимо для большинства людей, хотя слишком много усилий для вредоносного сайта бота.

Это также позволяет администратору сайта узнать, что к новым учетным записям прикреплен законный адрес электронной почты или номер телефона: большинство поддельных учетных записей «спама» не имеют таких опций.

2 Использование блокировки

Используйте функции блокировки и удаления учетной записи на вашем сайте, чтобы не пропустить все новые и старые учетные записи пользователей, которые могут быть ботами.

Кроме того, чтобы запретить новым ботам регистрироваться на вашем сайте, вы также должны убедиться, что избавились от любых старых ботов или неактивных учетных записей, которых там быть не должно.

Вы будете удивлены, насколько быстро спам-боты могут засорить сайт или учетную запись в социальной сети – и пока вы не просмотрите список пользователей, вы можете даже не знать, что они там были.

3 Использование капчи

Система Captcha была разработана для того, чтобы остановить спам-ботов с небольшими сложными задачами, которые вводят в заблуждение среднего бота.

Если вы заметили, что слишком много спам-комментариев проходят через ваш фильтр комментариев, возможно, пришло время добавить Captcha в раздел комментариев вашего сайта.

Вы сократите количество спам-ботов и комментарии почти мгновенно, гарантировано.

Для сайтов WordPress вы можете рассмотреть возможность использования решения для защиты от спама, такого как CleanTalk.

4 Модерация комментариев

Проверяйте раздел комментариев вашего сайта на регулярной основе.

Там вы можете удалить спам-комментарии, сделав это через автоматические процедуры, и, как правило, забанить этих пользователей.

Настройте ручную модерацию комментариев, если у вас есть серьезные проблемы с комментариями и спамом ботов.

Таким образом, каждый комментарий, размещенный на сайте, означает, что вы получили электронное письмо и должны были подтвердить его вручную.

Чтобы модерировать комментарии вручную, может потребоваться некоторое время, но иногда это единственный способ убедиться, что в разделе комментариев нет ботов и спама.

5 Изменение тега

Изобилие спама в папке входящих сообщений вашего сайта может означать, что боты привязались к тегу, который позволяет это сделать.

Проблема обычно заключается в странице “О сайте” или скрывается где-то в контактной форме сайта.

Выберите такую контактную форму, которая скрывает адрес электронной почты, на который идут электронные письма.

Если вы этого не сделаете, все, что нужно сделать боту, чтобы найти правильный адрес электронной почты, – это отсканировать исходный код, на котором адрес электронной почты в текстовом виде, а не внешний скрипт, к которому сложнее добраться.

6 Удаление неактивных пользователей и пользователей ботов

Точно так же, как и комментарии, пользователи также должны регулярно просматриваться администратором сайта.

Сследует проверять список подписчиков электронной почты и неактивных пользователей, а все то, что там не должно быть, необходимо удалить.

Пользователи ботов, которым удалось прокрасться через цепочку аутентификации при регистрации, легко идентифицировать и удалить, хотя неактивные учетные записи пользователей, содержащие только несколько сообщений, также должны быть удалены.

Неактивные учетные записи пользователей – это либо боты, либо они могут быть захвачены ботами: боты не всегда создают новые учетные записи, но могут также иногда захватывать старые и неактивные учетные записи для одного и того же использования.

Надеюсь, реализовав мероприятия, показанные выше, вы остановите вредносных ботов на вашем сайте.

Если вы используете CMS, такие как WordPress, Joomla, Drupal и т. д., вы можете также рассмотреть возможность использования облачной защиты безопасности, такой как SUCURI, не только для предотвращения спама, но и многих других онлайн-угроз.

- Как удалить ботов на сайте, избежать блокировок google /yandex с помощью botfaqtor

- ☎ Как обезопасить себя от спам-писем

- Безопасный WordPress против поддельного и одноразового почтового спама

- 13 лучших практик безопасности для защиты вашего сайта WordPress

- ⚓ Как заблокировать нежелательные User-Agent #128104;⚕️️ Как заблокировать ботов с помощью Cloudflare Firewall

Пожалуйста, не спамьте и никого не оскорбляйте. Это поле для комментариев, а не спамбокс. Рекламные ссылки не индексируются!

Добавить комментарий Отменить ответ

Поддержать нас

- Аудит ИБ (49)

- Вакансии (12)

- Закрытие уязвимостей (105)

- Книги (27)

- Мануал (2 281)

- Медиа (66)

- Мероприятия (39)

- Мошенники (23)

- Обзоры (813)

- Обход запретов (34)

- Опросы (3)

- Скрипты (113)

- Статьи (348)

- Философия (105)

- Юмор (18)

Наш Telegram

Социальные сети

Поделиться

Anything in here will be replaced on browsers that support the canvas element

- Как безопасно редактировать файлы конфигурации от имени определенного пользователя 28.04.2023

Безопасное редактирование конфигурационных файлов от имени конкретного пользователя. Убедитесь, что переменная окружения SUDO_EDITOR, VISUAL или, по крайней мере, EDITOR определена для предпочтительного текстового редактора. export EDITOR=»/usr/bin/vim» export SUDO_EDITOR=»$EDITOR» Редактирование определенного файла от имени root. Редактирование определенного файла в качестве zookeeper. Это гораздо лучше, чем использовать команду sudo, так как она явно раскрывает вашу систему. Все […]

Как вы знаете, знак $ в bash используется для обозначения переменных. Это тоже переменная, но другая. $0 – это одна из специальных переменных, которые есть в bash, и она используется для вывода имени файла скрипта, который в данный момент выполняется. Переменная $0 может быть использована в Linux двумя способами: Использовать $0 для поиска оболочки входа […]

Цифровые доказательства – это любая информация в цифровой форме, которая может быть полезна при проведении расследования. В этом блоге представлен обзор различных типов цифровых доказательств. Принцип обмена Локарда Принцип обмена Локарда для расследования – это убеждение, что если кто-то входит на место преступления, берет что-то с места преступления, а также что-то оставляет после себя. Применительно […]

В сегодняшнюю цифровую эпоху каждый бизнес в значительной степени зависит от технологий для эффективной и результативной работы. ИТ-инфраструктура, включая оборудование, программное обеспечение, сети и базы данных, лежит в основе любого современного предприятия. Это основа деятельности компании, и сбой или сбой в любой части ИТ-инфраструктуры может привести к значительным финансовым потерям, репутационному ущербу и даже несоблюдению […]

Искать поставщиков домашнего интернета становится проще благодаря сайтам-агрегаторам и их системе поиска. Разберём, как работает поиск провайдеров на примере маркетплейса ДомИнтернет. Определение геолокации Если у вашего браузера есть доступ к вашему местоположению, город на сайте определяется автоматически. Погрешность можно исправить, выбрав в меню правильный населённый пункт. Ввод адреса Здесь система напоминает работу Гугл-карт. Сайт располагает базой адресов, […]

Источник: itsecforu.ru